Chi raccoglie e ordina secondo criteri la gran parte della pubblicità nel mondo? Google. Cosa capisce di convenzioni della pubblicità e di teorie del linguaggio, o di analisi semantiche? Niente. Partendo da questa constatazione, nel 2008, Chris Anderson, all’epoca direttore di Wired, annunciò la fine del metodo scientifico, per come l’avevamo sempre considerato, o almeno dalla sua utilità. Disponendo di un diluvio di dati, non c’è alcun bisogno – sostenne – di costruire modelli teorici e vedere se funzionano. Basta individuare pattern di correlazioni. O meglio, lasciare che l’algoritmo, combinando i dati, determini che qualcosa produce un’altra cosa: che sia lui a chiarire come combattere un’influenza. Il successivo direttore di Wired, Kevin Kelly, ammorbidì la provocazione, affermando che l’impiego massiccio dei dati per la soluzione dei problemi non dimostra per forza che non vi sia una teoria alla base della loro combinazione: solo che non la conosciamo, e alla fin fine non è nemmeno tanto importante.

L’articolo di Anderson continua a pendere come spada di Damocle sulla reputazione del metodo scientifico, tant’è che l’ultimo numero della prestigiosa rivista francese Le Debat dedica alla sua sconfessione un’intera sezione composta di cinque autorevoli articoli. Non sono solo gli operai o i quadri, dunque, a temere di essere precocemente pensionati dallo sviluppo dell’intelligenza artificiale, ma pure gli scienziati.

Al momento, tuttavia, il metodo scientifico gode ancora di buona salute, nonostante l’IA si sia ulteriormente affinata imboccando la strada del deep learning, l’auto-apprendimento che ha ridotto il margine di errore nella valutazione dei dati e avvicinato (ma non sino a un punto di coincidenza) l’organizzazione dell’intelligenza artificiale a quella neuro-cerebrale. Resta un’illusione, però, che i dati possano essere puro materiale grezzo a disposizione dell’algoritmo. Essi riproducono pur sempre i bias cognitivi che li hanno formati. Per quanto in una selezione di personale l’algoritmo non patisca direttamente i pregiudizi e le deviazioni emotive di un responsabile delle risorse umane, i dati che andrà ad elaborare risentiranno della storia di quei pregiudizi e dei loro effetti discriminanti (e quindi saranno inclini a preferire uomini invece che donne nella selezione avente ad oggetto posti di alta responsabilità). Lo stesso avviene per la stretta ricerca a fini scientifici. Per quanto i dati possano essere un diluvio, come titolava l’articolo di Anderson, il legame di pertinenza che ne esclude alcuni e ne include altri non può che dipendere da un modello. Al contrario, il flusso dei dati può essere a posteriori la chiave di volta per verificare la validità di un modello (aiutare in sostanza la falsificabilità di Popper).

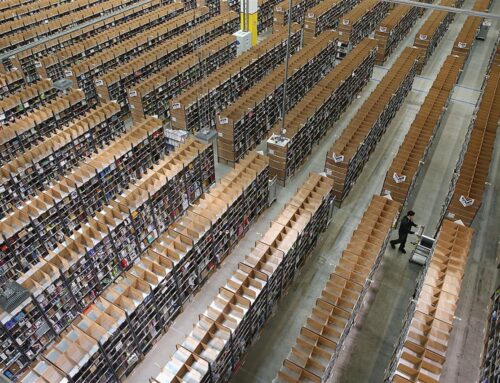

Secondo me è interessante che Anderson sia partito proprio dalla pubblicità: chiunque si occupi seriamente di usare la pubblicità a mezzo di algoritmi si rende conto che Anderson parla di qualcosa di cui nella pratica non capisce nulla. Se è vero che la pubblicità non è una scienza esatta, è ancora più insulso pensare che sia una statistica esattamente predittiva. Cominciamo col dire che la pubblicità è un sistema competitivo, e come in tutti i sistemi competitivi quel che preme all’interessato non è fare qualcosa nel modo corretto ma farlo in modo più efficace dei concorrenti. In linea di massima tutti possiamo allo stesso modo fruire positivamente di una statistica predittiva sulle previsioni del tempo: se invece tutti i produttori di cioccolato fossero avvantaggiati dalla medesima statistica predittiva se ne farebbero poco, e si troverebbero nella stessa condizione che se non l’avessero fatta. Google non valorizza la soggettività ma le impone di mettersi al servizio di aggregati oggettivi, e in modo macroscopico. Se siete il venditore di un servizio qualificato che vuole promuovere la sua attività, verranno utilizzate per voi aggregazioni statistiche che tenderanno a ripetere quelle di successo dei produttori di cioccolata. A quel punto, visto l’andamento negativo delle conversioni, dovrete saltare l’algoritmo e relazionarvi con un umano rappresentante di Google: che giustamente, non comprendendo i modelli al pari dell’algoritmo, non riuscirà comunque a indirizzarvi verso una strategia personalizzata.

Questa omogeneizzazione discende dall’idea, implicita nella nozione stessa di big data, che più dati è sempre meglio. Il guaio è che, controintuitivamente, l’incremento sproporzionato dei dati disponibili tende a falsare la pertinenza della correlazione. Un dato che ha un legame causale arbitrario con l’evento (e che si troverà infilato lì in assenza di un modello in grado di dare conto a priori della sua pertinenza) rischia di falsare la valutazione. È in un certo senso quel che accade con la superstizione, ed in particolare a carico di quelli che si fanno la fama di iettatori. Ricordo da ragazzo quanto a me e ai miei amici paressero inoppugnabili le correlazioni che esistevano tra l’accadimento reiterato di certi eventi disgraziati e la presenza fisica o nominale di una certa persona. Ovviamente (almeno spero!) si trattava di un ingenuità, dovuta all’inserimento di un fattore di correlazione inappropriato.

Fritjof Capra (famoso per il Tao della fisica) ha scritto qualche anno fa un affascinante saggio, Vita e natura. Una visione sistemica. Anche lui esalta il valore dei pattern in luogo dei legami di causa ed effetto della fisica meccanica. Probabilmente esagera nella sua enfasi olistica ma, ciò che è importante, non la poggia sulle correlazioni ma sulle relazioni. Come scrive su Le Debat Marc Mezard, il fisico direttore dell’Ecole normale supérieure, delle relazioni fanno parte il contesto, l’analisi causale e l’aggiustamento delle perturbazioni. È quest’ultimo l’anello platealmente debole delle predizioni statistiche dei big data (e più in generale dell’IA): la difficoltà di correzione di fronte all’imprevisto. Risulta così ancora possibile che dei ricercatori possano mettere in crisi un sistema di riconoscimento fondato sulle reti di neuroni profondi fissando un adesivo a lato dell’immagine di una banana e ingannare la macchina al punto che – chissà per effetto di quali correlazioni! – lo scambia per un tostapane.

In conclusione, i dati sono un enorme valore aggiunto, nel medio periodo direi decisivo, di qualsiasi sistema predittivo. Ma se li si colloca ingenuamente al vertice della piramide conoscitiva presentano almeno due difetti: uno è quello di una distorsiva matematizzazione del mondo (di alcuni effetti nefasti avevo scritto qui); l’altro è quel generico atteggiamento ideologico, estratto dall’uso massiccio della tecnologia, che si può riassumere nel motto non chiederti perché, il cui destino non è introdurre alla predizione ma all’imbecillità.

Scrivi un commento